芯东西(ID:aichip001)文 | 云鹏 心缘

芯东西3月5日消息,《Nature》刊登一则新研究,提供了一种新颖的AI视觉芯片研发方向。

维也纳大学的电气工程师Lukas Mennel和他的同事们研发了一种新型的超高速机器视觉设备,用图像传感器将图像处理速度提升至传统技术的数千甚至上万倍。

Mennel介绍说:“我们的图像传感器在工作时不会消耗任何电能,被检测的光子本身就可以作为电流供能。”

他着重提到,传统的机器视觉技术通常能够每秒处理100帧图像,一些更快的系统则可以每秒处理1000帧,相比之下,“我们的系统每秒可以处理2000万帧。”

据悉,其视觉系统设计模仿了大脑对信息处理的方式,只用纳秒级时间就能完成简单图像的分类。

Nature 579, 32-33 (2020)

doi: 10.1038/d41586-020-00592-6

一、将图像传感器变成人工神经网络现代图像传感器最早在1970年代初开发出来,主要分为电荷耦合器件和有源像素传感器两种类型。

这些传感器能从环境中准确捕获视觉信息,但同时也会生成大量冗余数据,而传感器与处理单元之间大量数据的移动,往往会导致高功耗和延迟问题。

如今汽车、

机器人、工业制造等领域的视觉应用都对延迟非常敏感,要求尽可能实现实时处理和决策,而受带宽限制,把所有数据都送到云端处理很难解决延时问题,边缘计算逐渐成为刚需。

另外,由于传感器通常会产生模拟输出,而模数转换既耗时又耗能,因此模拟处理要好过数字处理。

维也纳大学研究人员们试图通过减少中间步骤来加快机器视觉,他们直接在图像传感器中实现了人工神经网络(

ANN)。

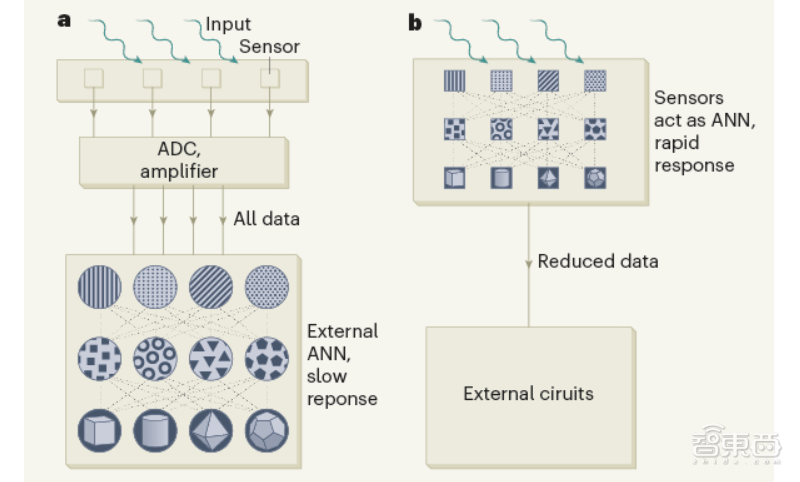

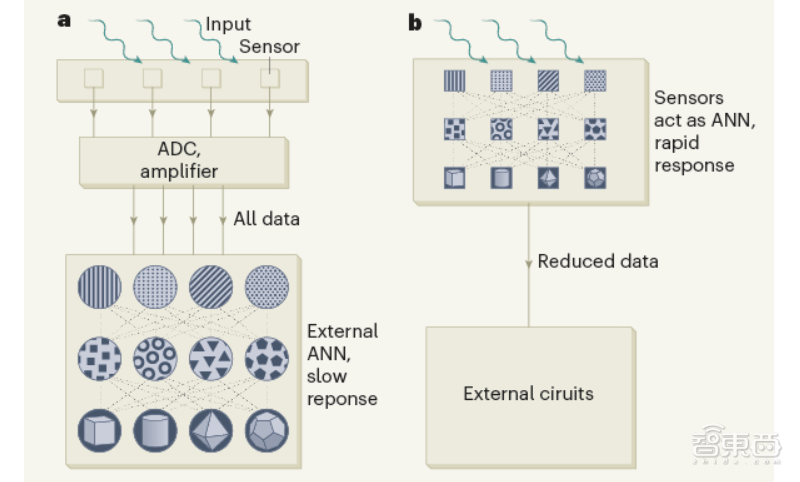

▲ 输入信息在视觉传感器内进行计算,实现智能,高效的预处理

传统AI视觉传感器的处理过程如图(a)所示,传感器收集信号,通过模数转换器(ADC)将模拟信号转换为数字信号,放大后输入到外部人工神经网络(ANN),经参数调优训练神经网络。

ANN的输入层接收编码简单物理元素的信号(点、线),这些信号在随后的层中被优化为中级特征(简单形状),最后在输出层上形成精细的图像(3D形状),总体响应可能很慢而且耗能。

而Mennel等人研发的视觉系统如图(b)所示,芯片上的互连传感器(正方形)不仅可以采集信号,而且还可以用作ANN来识别简单特征,从而减少了传感器和外部电路之间的冗余数据移动。

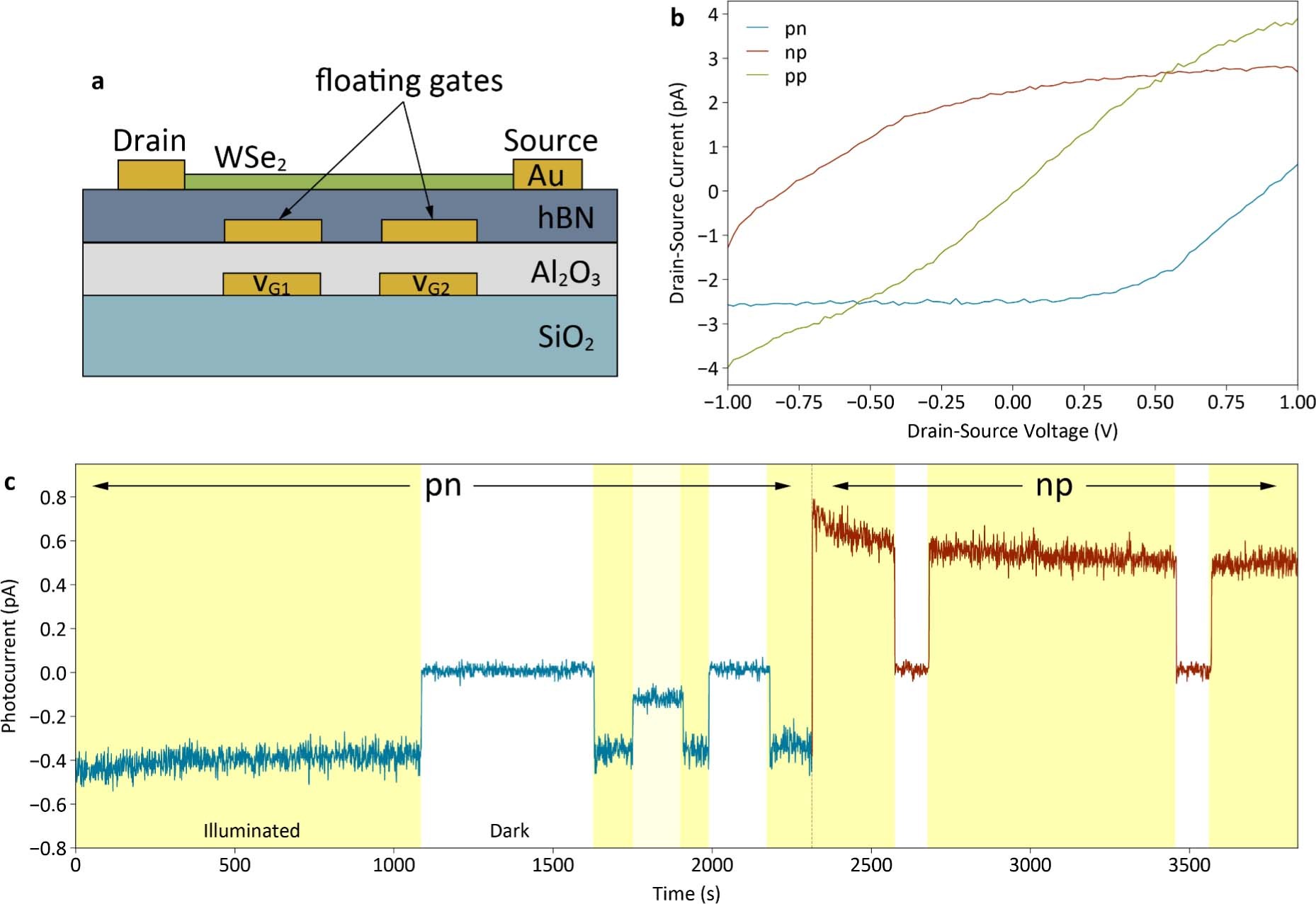

二、传感器中集成权重,减少冗余数据移动研究人员们在芯片上构建了一个光电二极管网络。

这些光电二极管是对光敏感的微小单元,每个单元都包含几个原子层的二硒化钨,二硒化钨是一种可调节光响应的二维半导体材料。

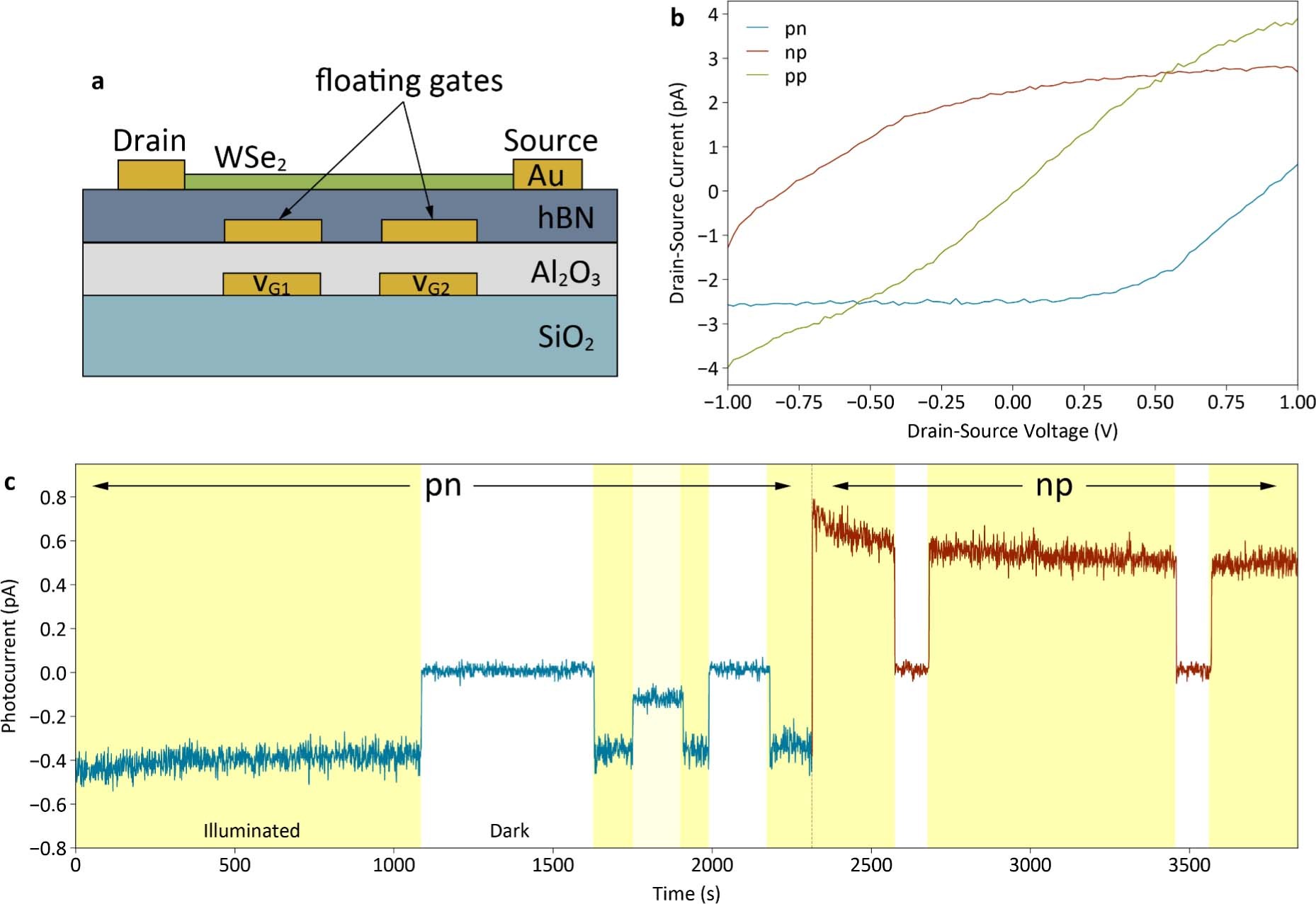

▲浮栅光电二极管示意图

通过更改施加的电压,可以增加或减少该半导体对光的响应,从而分别调节每个二极管的灵敏度。

改变光电二极管的光响应性,会改变网络中的连接权重。

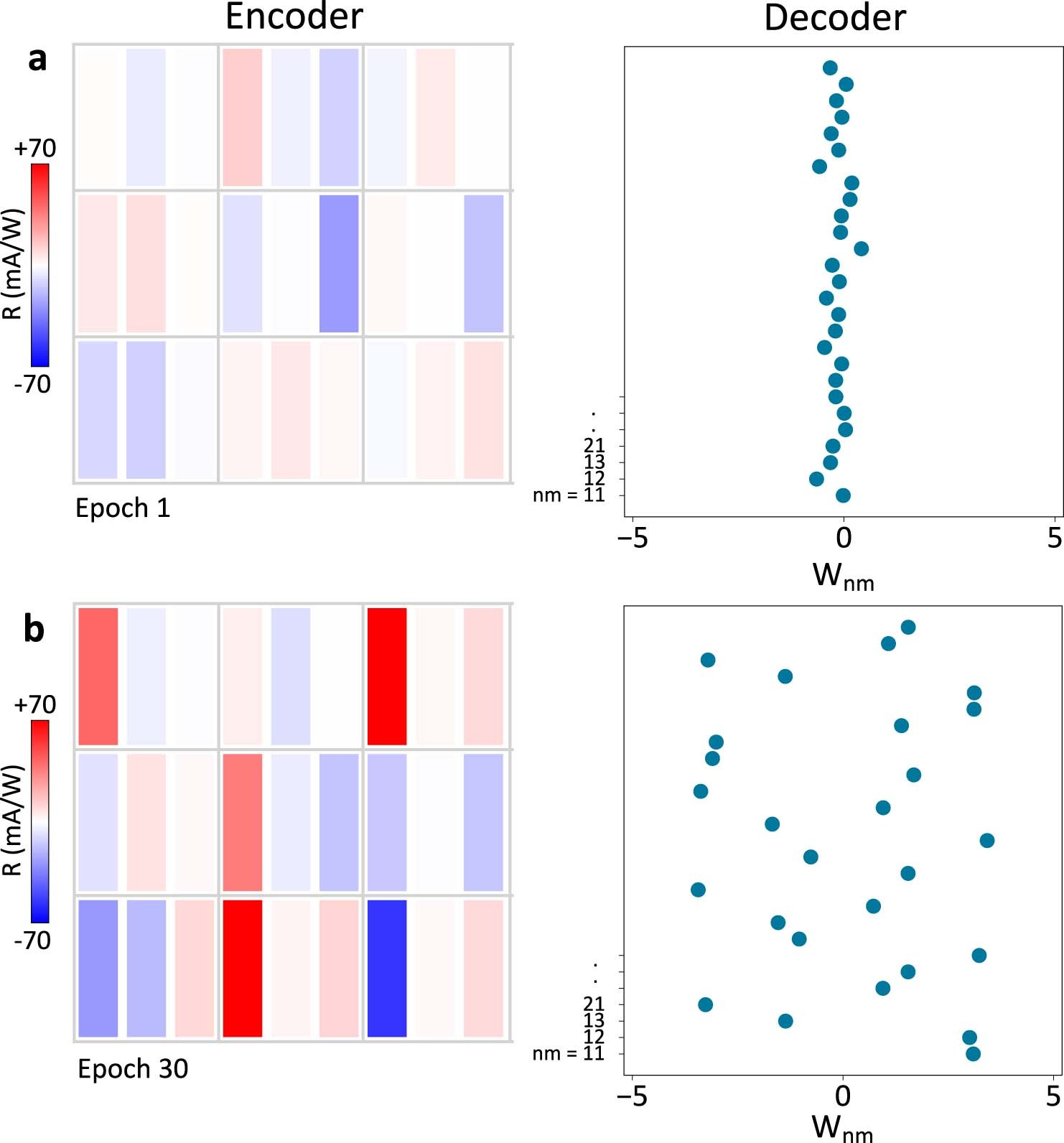

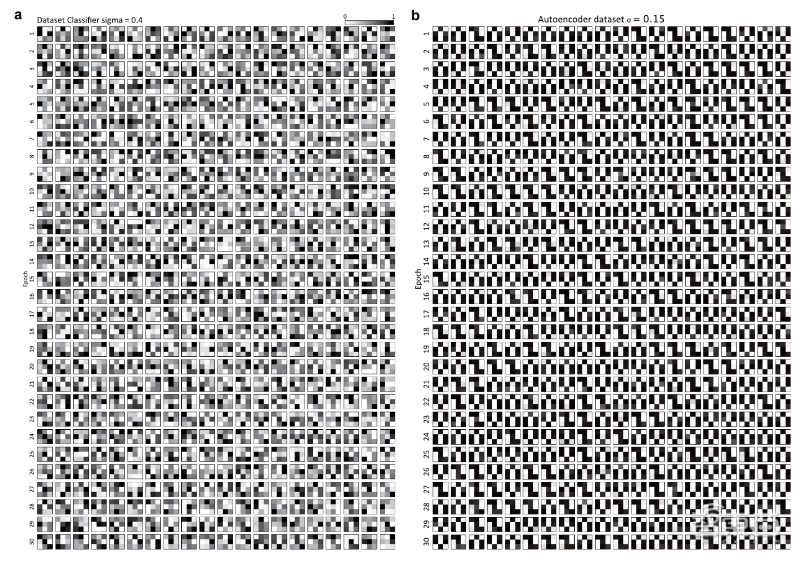

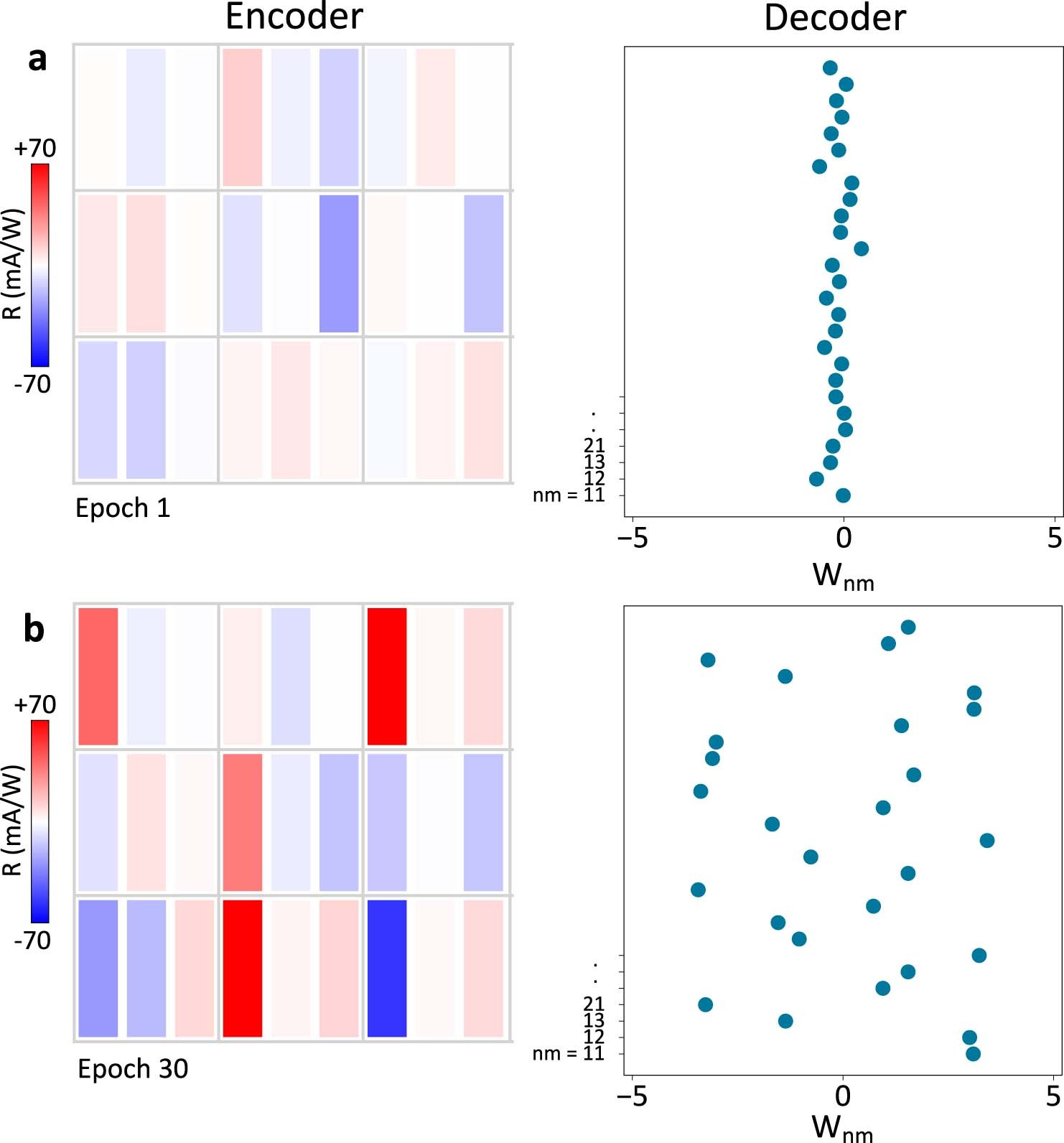

▲epoch 1和epoch 30时的编码器光响应值(左)和解码器权重(右)

相当于把网络的训练结果直接放在传感器端,不用经过把训练权重送到外部存储器这一过程。

这就将光电传感器网络变成了神经网络,并使其能够执行简单的计算任务。

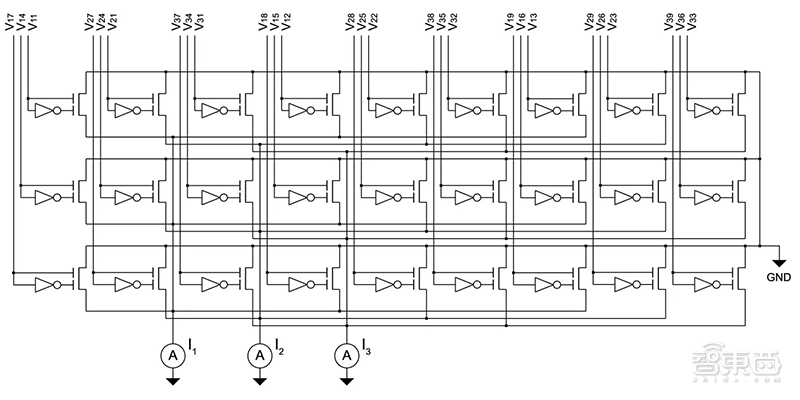

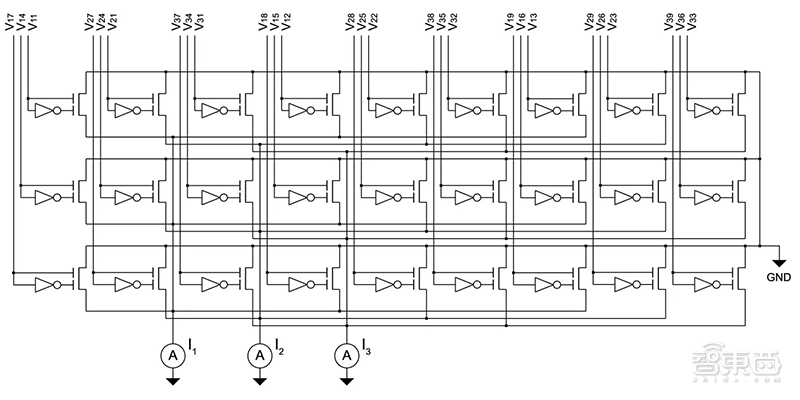

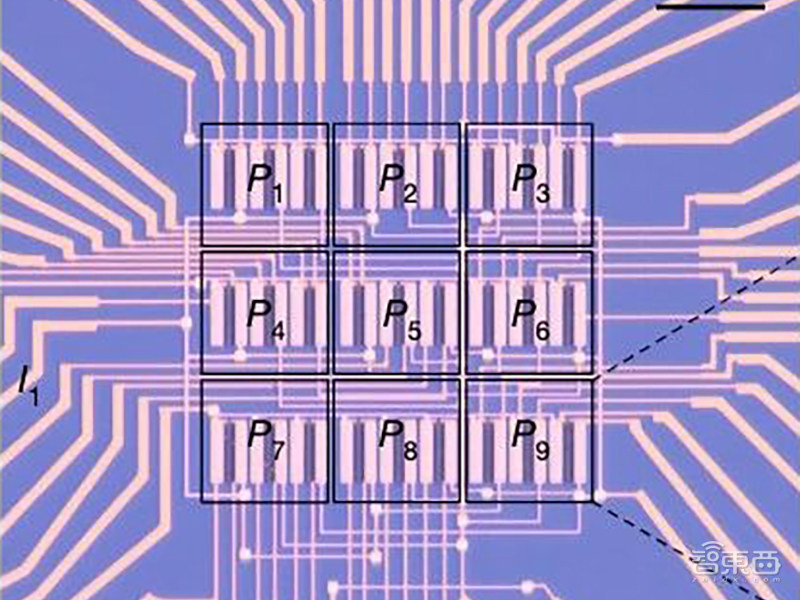

▲ ANN光电二极管阵列的电路

研究人员们将光电二极管排列成9个像素的正方形阵列,每个像素3个二极管。

当图像投影到芯片上时,芯片会生成、读取各种二极管产生的电流。

硬件阵列提供了一种模拟计算形式:每个光电二极管都会产生与入射光强度成比例的输出电流,并且根据基尔霍夫定律将沿行或列得出的电流相加。

然后就可以训练阵列来执行相应任务了。

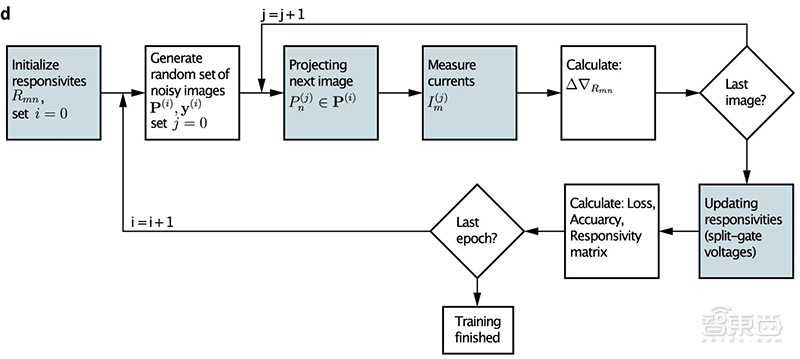

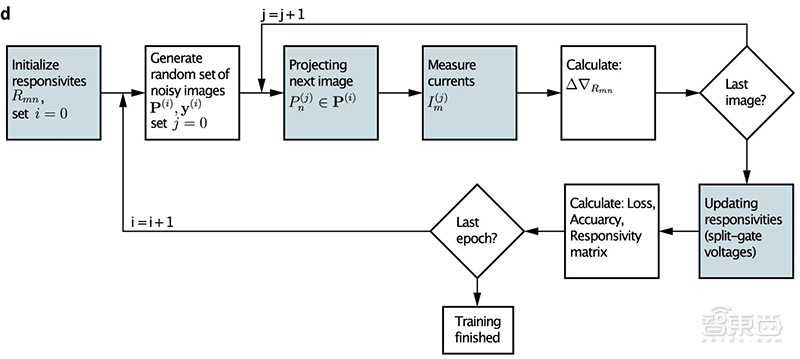

▲训练算法流程图(蓝色阴影框是与ANN光电二极管阵列的相互作用)

芯片外分析阵列产生的电流与预测电流之间的差异,并用于调整突触权重以进行下一次训练周期。

这个学习阶段会占用时间和计算资源,但是一旦经过训练,该芯片就会迅速执行其设定的任务。

使用不同神经网络算法,该团队演示了两种神经形态功能:分类和自动编码。

▲a:用于训练分类器和自动编码器的实验设置;b:用于时间分辨测量的实验设置

(1)分类

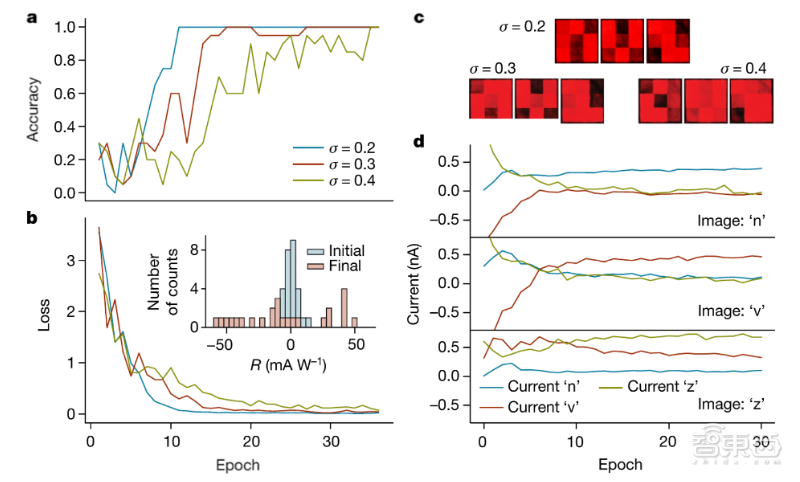

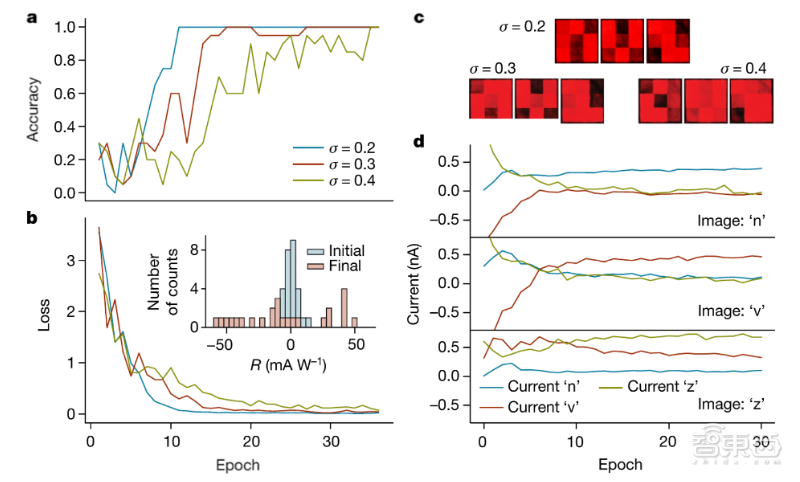

他们用3×3像素阵列制作了三个简化字母:n、v、z。

图像传感器经训练后,只需测量对应电路电流是否为0,就能在纳秒级时间内识别该字母。

如果按比例增加阵列的大小,该神经网络还可以识别更复杂的图像。

▲识别“n”、“v”、“z”三个字母

(2)自动编码

即使在存在信号噪声的情况下,该神经网络也可以通过学习图像的关键特征,来生成处理后图像的简化表示。

编码器仅包含最基本的信息,但可以对其进行解码以重建接近原始图像。

▲对有噪声图像的简化表示

Mennel指出,系统运行的速度仅受电路中电子移动速度的限制。从原则上讲,这种策略的工作速度可以达到数万亿分之一秒,或者比目前演示的速度快三到四个数量级。

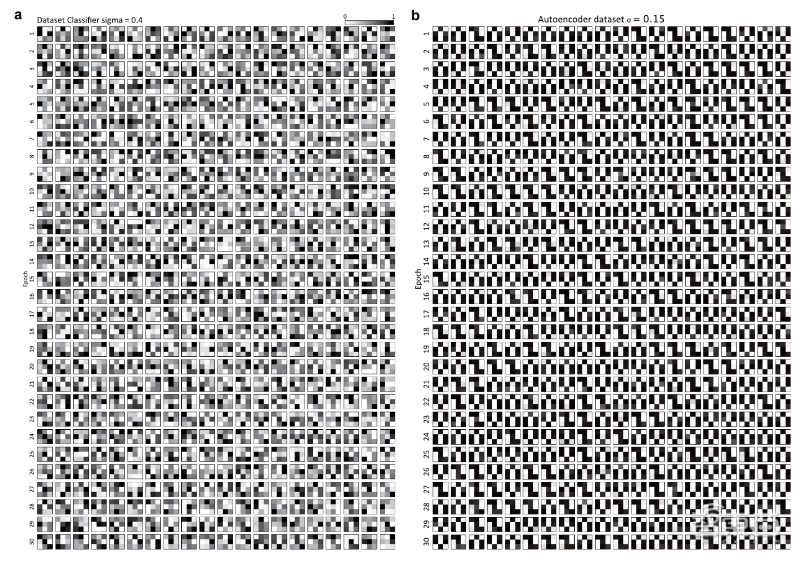

▲分类器(a)和自动编码器训练(b)30 epoches的数据集,其测试数据噪声水平分别为

σ = 0.4和

σ = 0.15

这样的传感器可以用来做什么?

Mennel说:“目前,这些主要用在特定的科学应用,例如,流体动力学、燃烧过程或机械故障过程可从更快的视觉数据获取中受益。”

不过,这项技术在实际落地应用之前,还有许多工作要做。

首先,用于自动驾驶车辆和机器人技术的神经形态视觉系统,需要捕获具有广阔视野的三维动态图像和视频。

而当前使用的图像捕获技术通常将3D现实世界转换为2D信息,丢失运动信息和深度,现有图像传感器阵列的平面形状也限制了广角相机的发展。

其次,该研究描述的设备很难在昏暗的光线下成像,需要重新设计,以改善薄半导体中的光吸收,并增加可以检测到的光强度范围。

再者,该设计需要高电压并消耗大量功率。相比之下,生物神经网络中每项操作的能量消耗为10 -15至10 -13焦耳。扩展对紫外线和红外光的响应,以捕获在可见光谱不可用的信息也是有用的。

另外所使用的薄半导体难以在大面积上均匀地生产,并且难以加工,因此它们可以与硅电子器件集成在一起,例如用于读出或反馈控制的外部电路。

使用这些传感器的设备的速度和能源效率将不取决于图像捕获过程,而是取决于传感器和外部电路之间的数据移动。

而且,尽管传感器计算单元在模拟域中采集和计算数据,减少了模数转换,但是外围电路仍然存在固有延迟问题。传感器和外部电路将需要共同开发来减少整个系统的等待时间。

结语:实时边缘计算的创新路径Mennel及其同事的“传感器中计算”系统是对AI硬件研究非常有趣的探索。

此前少数公司已经开发了基于硅电子的AI视觉芯片,但这些芯片的固有数字体系结构往往带来延迟和电源效率问题。

更广泛地说,该研究团队的策略不仅限于视觉系统,它可以扩展到用于听觉、触觉、热感以及嗅觉等其他物理输入。

此类智能系统的开发以及

5G高速无线网络的到来,会让实时(低延迟)边缘计算成为可能。

文章来源:IEEE,Nature

|站点统计|小黑屋|手机版|Archiver|摄像头模组论坛网-摄像头方案网CCM99

( 粤ICP备18155214号 )

|站点统计|小黑屋|手机版|Archiver|摄像头模组论坛网-摄像头方案网CCM99

( 粤ICP备18155214号 )

窥视卡

窥视卡 雷达卡

雷达卡 发表于 2020-3-9 18:45:05

发表于 2020-3-9 18:45:05

▲ 输入信息在视觉传感器内进行计算,实现智能,高效的预处理

▲ 输入信息在视觉传感器内进行计算,实现智能,高效的预处理 ▲浮栅光电二极管示意图

▲浮栅光电二极管示意图 ▲epoch 1和epoch 30时的编码器光响应值(左)和解码器权重(右)

▲epoch 1和epoch 30时的编码器光响应值(左)和解码器权重(右) ▲ ANN光电二极管阵列的电路

▲ ANN光电二极管阵列的电路

▲训练算法流程图(蓝色阴影框是与ANN光电二极管阵列的相互作用)

▲训练算法流程图(蓝色阴影框是与ANN光电二极管阵列的相互作用) ▲a:用于训练分类器和自动编码器的实验设置;b:用于时间分辨测量的实验设置

▲a:用于训练分类器和自动编码器的实验设置;b:用于时间分辨测量的实验设置 ▲识别“n”、“v”、“z”三个字母

▲识别“n”、“v”、“z”三个字母 ▲对有噪声图像的简化表示

▲对有噪声图像的简化表示 ▲分类器(a)和自动编码器训练(b)30 epoches的数据集,其测试数据噪声水平分别为σ = 0.4和σ = 0.15

▲分类器(a)和自动编码器训练(b)30 epoches的数据集,其测试数据噪声水平分别为σ = 0.4和σ = 0.15 提升卡

提升卡 置顶卡

置顶卡 沉默卡

沉默卡 喧嚣卡

喧嚣卡 变色卡

变色卡 千斤顶

千斤顶 显身卡

显身卡